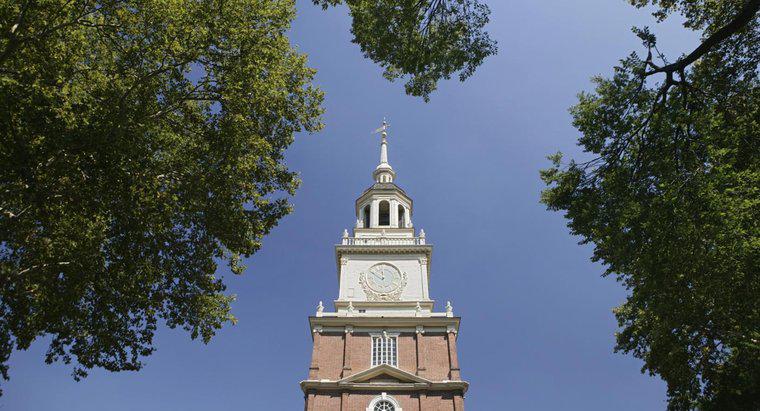

Die Vereinigten Staaten wurden am 4. Juli 1776 ein Land, als der Kontinentalkongress die Unabhängigkeitserklärung offiziell billigte. Das erste Mal, dass ein fremdes Land die Vereinigten Staaten offiziell als unabhängig anerkannte, war jedoch 1777, als Marokko die Unabhängigkeit der Vereinigten Staaten anerkannte.

1778 erkannte Frankreich die Vereinigten Staaten als souveräne Nation an, als Vertreter beider Länder den Freundschafts- und Handelsvertrag und den Allianzvertrag unterzeichneten. Die nächste Großmacht, die die Vereinigten Staaten als Nation anerkannte, war 1781 Dänemark. Großbritannien, obwohl es sich 1781 den Vereinigten Staaten ergab, erkannte die Vereinigten Staaten erst mit der Unterzeichnung des Pariser Vertrags im Jahr 1783 formell als Souverän an.< /p>