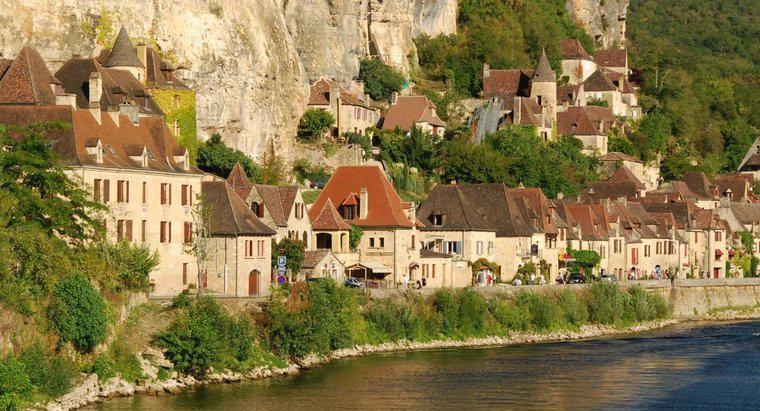

Rassismus in den Vereinigten Staaten gibt es seit dem 14. Jahrhundert, als europäische Siedler begannen, Amerika zu kolonisieren. In ihrem Bestreben, die Menschen zu "zivilisieren", begannen die Europäer, Sklaven zu nehmen und Menschen zu behandeln, die anders aussahen von ihnen als minderwertig.

Die ersten rassistischen Handlungen fanden gegen die Ureinwohner Amerikas statt. Als die Europäer in Amerika landeten, besiegten sie die Indianer in Kriegen und Massakern. Die Überlebenden litten unter erzwungenen Verträgen, Lebensmittelbeschränkungen und Landbeschlagnahmen. Die europäischen Siedler versuchten, den amerikanischen Ureinwohnern das Christentum aufzuzwingen, und diejenigen, die sich nicht anpassten, wurden oft bestraft.

Afroamerikaner stehen seit der Besiedlung von Virginia durch die ersten englischen Kolonisten im Mittelpunkt des Rassismus. Sie wurden als Sklaven genommen und oft geschlagen, ausgehungert und wie Tiere behandelt.